近日,信息与智能工程学院的吴涛老师开展了一场主题为“大模型的前世今生”的精彩分享讲座,吸引了众多师生到场聆听,在校园内掀起了一股探索人工智能前沿技术的热潮。

讲座伊始,吴涛老师以通俗易懂的方式阐释了什么是大模型。他介绍道,大模型是指使用大规模数据和强大的计算能力训练出来的“大参数”模型,具有高度的通用性和泛化能力,涵盖语言、视觉等多模态领域,可细化为通用、行业及任务特定模型。与传统AI模型相比,大模型的显著特征在于参数量大、数据量大、计算量大,是“大数据+大算力+强算法”结合的产物,堪称凝聚大数据内在精华的“隐式知识库”。

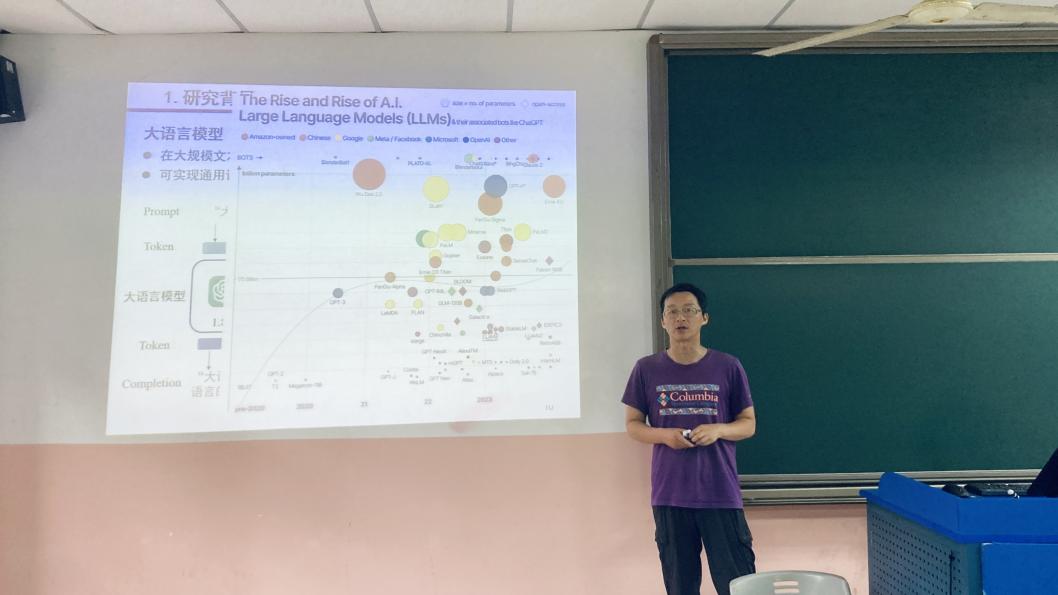

谈及大模型的发展历程,吴老师带领大家回溯历史。从1950年计算机专家约翰・麦卡锡提出“人工智能”概念起,AI发展从基于小规模专家知识逐步走向机器学习。1980年卷积神经网络的雏形CNN诞生,1998年现代卷积神经网络的基本结构LeNet-5出现,机器学习方法从浅层机器学习模型转变为基于深度学习的模型,为后续大模型发展奠定基础。2006-2019年的沉淀期,以Transformer为代表的全新神经网络模型崭露头角。2013年自然语言处理模型Word2Vec诞生,2014年GAN诞生,2017年Google提出Transformer架构,2018年OpenAI和Google分别发布GPT-1与BERT大模型,预训练大模型成为自然语言处理领域主流。2020年OpenAI推出的GPT-3,参数规模达1750亿,在零样本学习任务上性能大幅提升。2022年搭载GPT3.5的ChatGPT横空出世,引爆互联网,随后Gemini、文心一言等各种大模型如雨后春笋般涌现,2022年也被誉为大模型元年。2023年发布的GPT-4,具备多模态理解与多类型内容生成能力,标志着大数据、大算力和大算法的完美结合。

在关键技术方面,吴涛老师着重讲解了三项核心技术。首先是大模型底层的神经网络架构Transformer,其利用自注意力机制解决了序列建模中的循序计算问题,大幅提升并行计算能力和长距离依存关系建模能力,开启了模拟人类智能的新范式。其次是基于自监督学习的预训练技术及扩展法则,将各类任务统一表示为生成式问题,通过自监督学习在大规模人类语言数据上训练模型,并依据扩展法则指导模型与数据规模的协同扩展。最后是后训练阶段的精调和对齐技术,通过有监督精调及人类反馈强化学习,让预训练大模型理解人类意图、遵循指令、对齐人类价值观。

讲座的最后,吴涛老师分享了大模型在多个领域的广泛应用。在医疗领域,大模型可辅助医生进行精准疾病诊断,如通过分析医学影像和病历数据诊断癌症、肺炎等,还能助力药物研发,模拟生物体内化学反应加速新药研发进程。金融领域中,大模型用于精准风险评估和信用评估,智能风控系统能实时监测金融市场风险变化,智能投顾服务可根据用户投资需求和风险偏好提供个性化投资组合方案。交通领域,基于大模型的智能交通指挥系统能实时分析交通流量调整信号灯时间,缓解交通拥堵;在智能汽车开发中,大模型通过自动驾驶技术和车辆管理系统,提升出行的安全性和高效性。此外,大模型在工业设计、芯片设计、人形机器人等行业也有诸多应用,推动着各行业的智能化转型升级。

此次讲座让师生们对大模型有了全面且深入的认识,激发了大家对人工智能前沿技术的浓厚兴趣。不少同学表示,讲座拓宽了自己的学术视野,未来将积极投身相关领域的学习与研究,探索大模型技术更多的可能性。吴涛老师的分享不仅为校园带来了前沿的学术知识,也为培养适应时代发展的创新型人才注入了新的动力。